Corporativo > Tecnología

Samsung presenta TRUEBench: un benchmark para la productividad real de la IA

https://bit.ly/475eF5E

Registrado a ►Costa Rica ►Ecuador ►El Salvador ►Guatemala ►Honduras ►Nicaragua ►Panamá ►Paraguay ►Puerto Rico ►República Dominicana ►Uruguay ►Venezuela

El benchmark propietario respalda escenarios de productividad multilingüe, abordando las brechas de los benchmarks de IA existentes

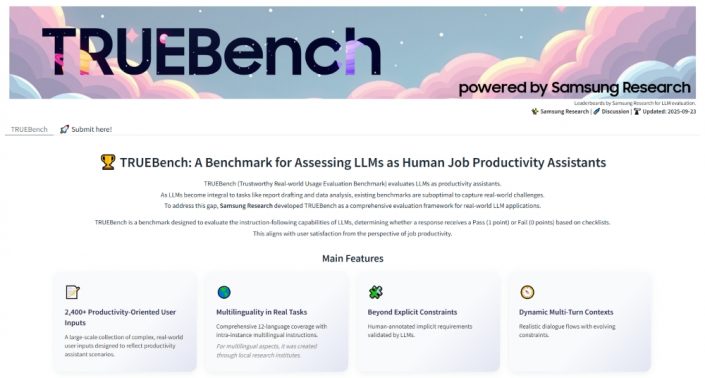

Samsung Electronics presentó hoy TRUEBench (Trustworthy Real-world Usage Evaluation Benchmark), un benchmark propietario desarrollado por Samsung Research para evaluar la productividad de la IA.

TRUEBench ofrece un conjunto integral de métricas para medir cómo los modelos de lenguaje de gran escala (LLM, por sus siglas en inglés) se desempeñan en aplicaciones reales de productividad en el lugar de trabajo. Para garantizar una evaluación realista, incorpora diversos escenarios de diálogo y condiciones multilingües.

Basado en el uso interno de IA de Samsung para la productividad, TRUEBench evalúa tareas empresariales comúnmente utilizadas – como generación de contenido, análisis de datos, resumen y traducción – en 10 categorías y 46 subcategorías. El benchmark asegura una puntuación confiable con evaluación automática impulsada por IA, basada en criterios diseñados y refinados de manera colaborativa tanto por humanos como por IA.

“Samsung Research aporta una profunda experiencia y una ventaja competitiva gracias a su experiencia en IA aplicada al mundo real”, dijo Paul (Kyungwhoon) Cheun, CTO de la División DX de Samsung Electronics y director de Samsung Research. “Esperamos que TRUEBench establezca estándares de evaluación para la productividad y consolide el liderazgo tecnológico de Samsung”.

Recientemente, a medida que las empresas adoptan la IA para sus tareas, ha crecido la demanda de medir la productividad de los LLM. Sin embargo, los benchmarks existentes miden principalmente el desempeño general, se centran en el inglés y se limitan a estructuras de preguntas y respuestas de una sola interacción. Esto restringe su capacidad de reflejar entornos laborales reales.

Para abordar estas limitaciones, TRUEBench está compuesto por un total de 2.485 conjuntos de prueba en 10 categorías y 12 idiomas[1], además de admitir escenarios interlingüísticos. Los conjuntos de prueba examinan lo que los modelos de IA realmente pueden resolver, y Samsung Research aplicó pruebas que van desde apenas 8 caracteres hasta más de 20.000 caracteres, reflejando tareas que van desde solicitudes simples hasta resúmenes extensos de documentos.

Para evaluar el rendimiento de los modelos de IA, es importante contar con criterios claros para determinar si las respuestas son correctas. En situaciones reales, no todas las intenciones del usuario se expresan explícitamente en las instrucciones. TRUEBench está diseñado para permitir una evaluación realista al considerar no solo la exactitud de las respuestas, sino también condiciones detalladas que satisfagan las necesidades implícitas de los usuarios.

Samsung Research verificó los ítems de evaluación mediante la colaboración entre humanos e IA. En primer lugar, los anotadores humanos crean los criterios de evaluación, luego la IA los revisa para detectar errores, contradicciones o restricciones innecesarias. Posteriormente, los anotadores humanos refinan nuevamente los criterios, repitiendo este proceso para aplicar estándares de evaluación cada vez más precisos. Con base en estos criterios verificados de forma cruzada, se realiza la evaluación automática de los modelos de IA, minimizando el sesgo subjetivo y garantizando la consistencia. Además, para cada prueba, todas las condiciones deben cumplirse para que el modelo apruebe. Esto permite una puntuación más detallada y precisa en todas las tareas.

Las muestras de datos y los rankings de TRUEBench están disponibles en la plataforma global de código abierto Hugging Face, lo que permite a los usuarios comparar un máximo de cinco modelos y obtener una visión integral del rendimiento de los modelos de IA de un solo vistazo. Además, también se publican datos sobre la longitud promedio de las respuestas, lo que posibilita comparar simultáneamente tanto el rendimiento como la eficiencia. La información detallada se puede encontrar en la página de TRUEBench en Hugging Face: https://huggingface.co/spaces/SamsungResearch/TRUEBench.

[1] Chino, inglés, francés, alemán, italiano, japonés, coreano, polaco, portugués, ruso, español y vietnamita

Para cualquier problema relacionado con servicio al cliente, por favor comuníquese a samsung.com/latin/info/contactus para obtener ayuda. Para consultas de medios, por favor contacte a prensa.sela@samsung.com.